前編ではデータを加工するデータフローの作成までを紹介しましたが、後編である今回は、データ処理を自動化するパイプラインの構築と通知設定、データの可視化までを紹介します。

前編はこちらですので、併せてご覧ください。

- データの取得・加工・格納を自動化するパイプラインの構築

- パイプライン実行時に古いデータを削除する

- パイプラインの通知設定

- パイプラインの定期実行

- データのクリーンアップについて

- パイプラインの動作確認

- データの可視化

- まとめ

データの取得・加工・格納を自動化するパイプラインの構築

前編で作成した生データをレイクハウスに取り込むパイプライン(test_pileline)に、データ加工を行うデータフロー(test_dataflow)を接続します。

このようにパイプラインを構築することで、レイクハウスへのデータ収集からデータフローによるデータ加工、さらに加工後のウェアハウスへの格納を自動化することが可能になります。

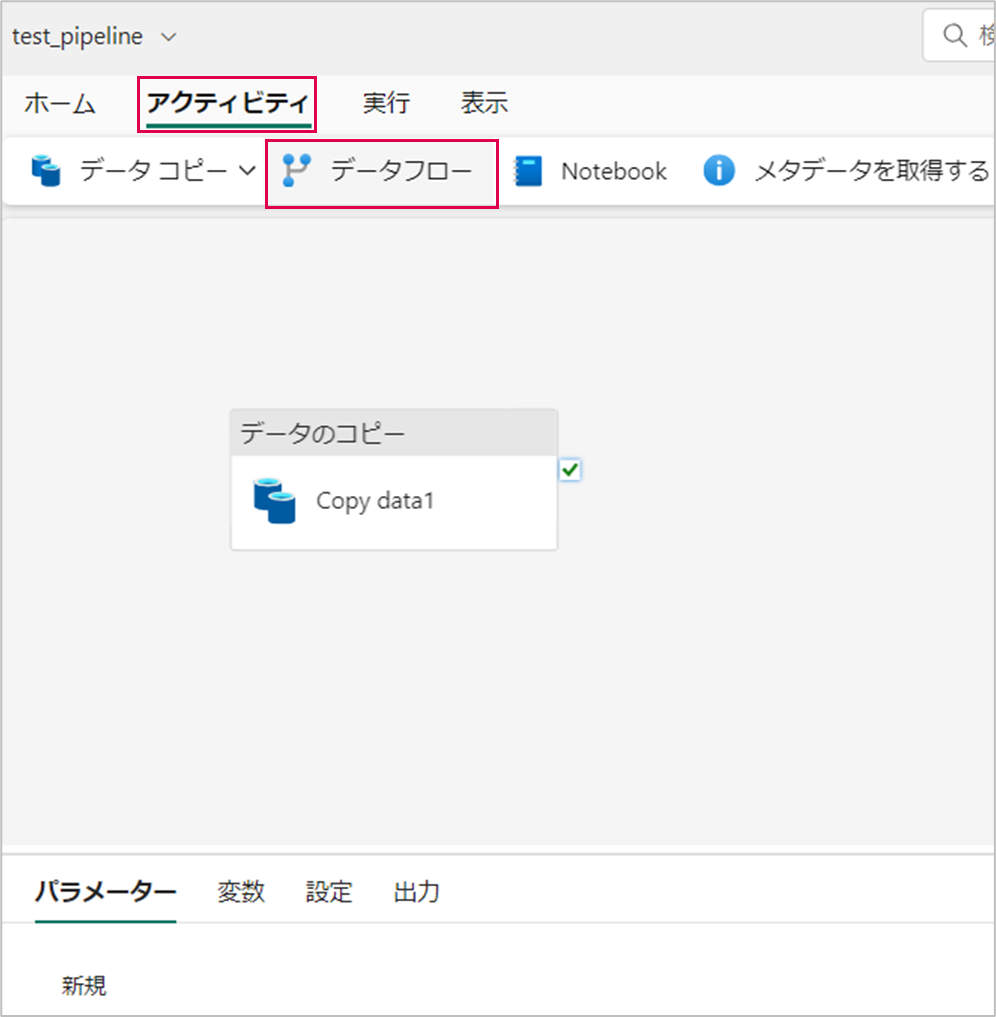

パイプライン(test_pipeline)を開き、「アクティビティ」>「データフロー」の順に押下します。

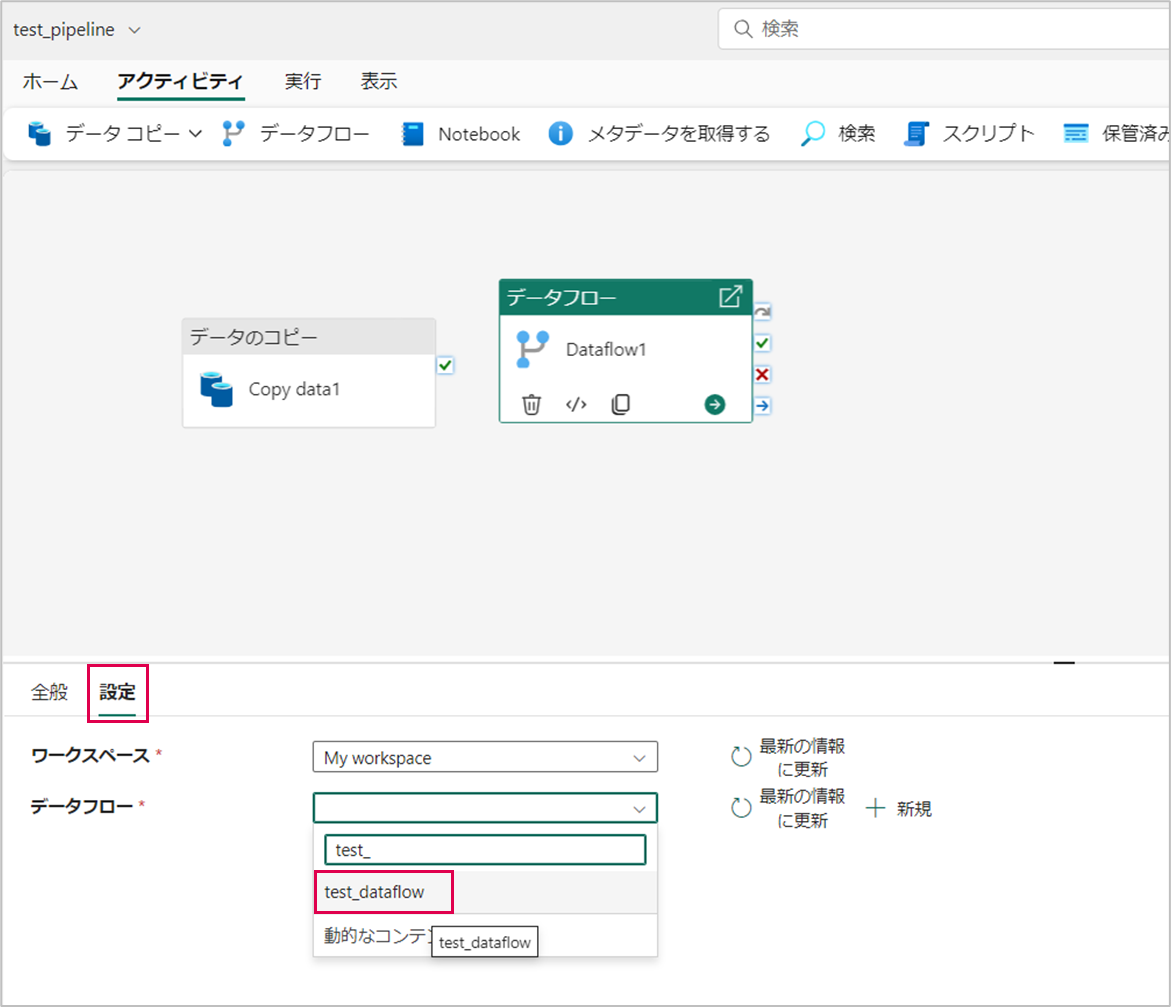

データフローアクティビティの「設定」タブを開き、「データフロー」を「test_dataflow」に設定します。

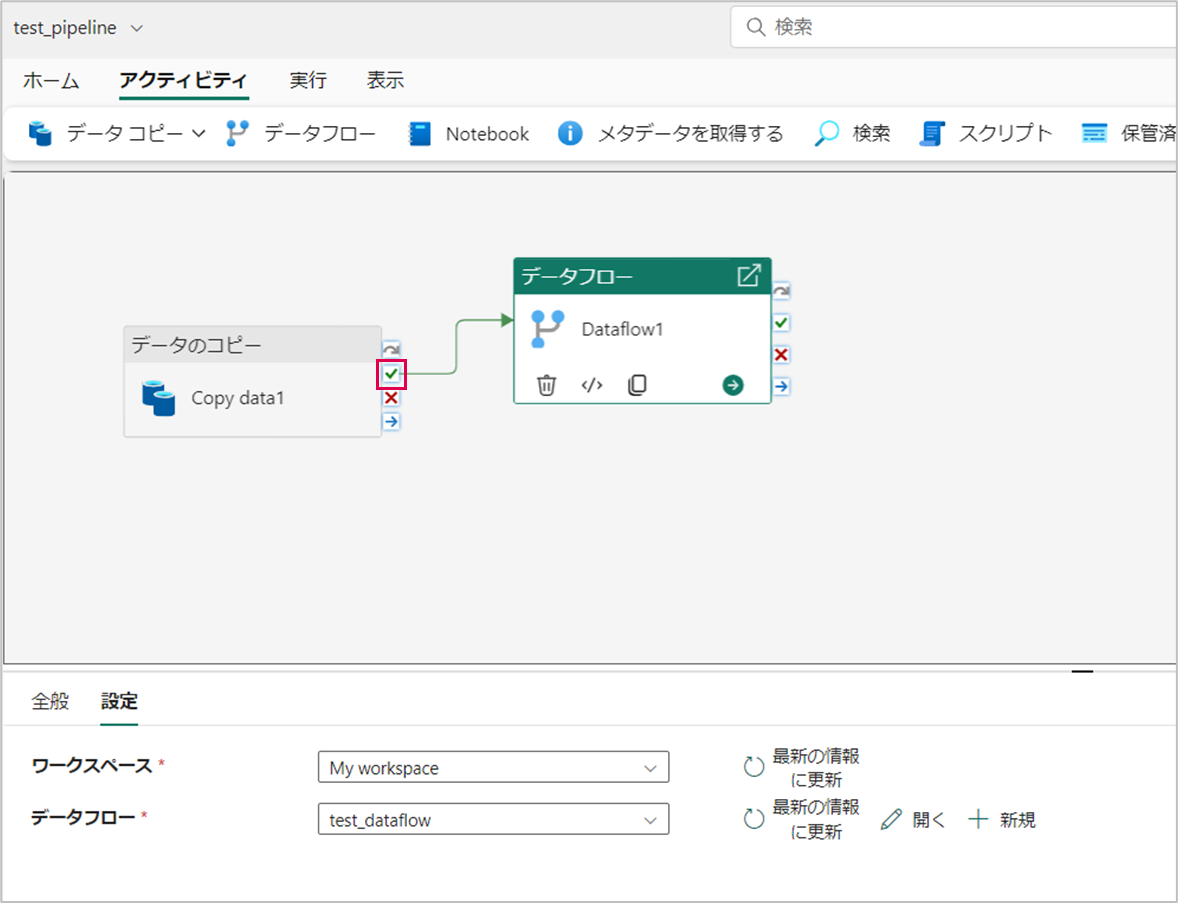

データのコピーアクティビティにカーソルを合わせて、「緑色チェックマーク(成功時)」から矢印を伸ばし、データフローアクティビティに接続します。

これで、データの取得・加工・格納を自動化するパイプラインの構築が完了しました。

パイプライン実行時に古いデータを削除する

パイプラインの「データの削除」アクティビティを使用すると、パイプライン実行時に古いデータを削除することができます。パイプライン実行時に古いデータを削除することで、確実に最新のデータを取得することができます。

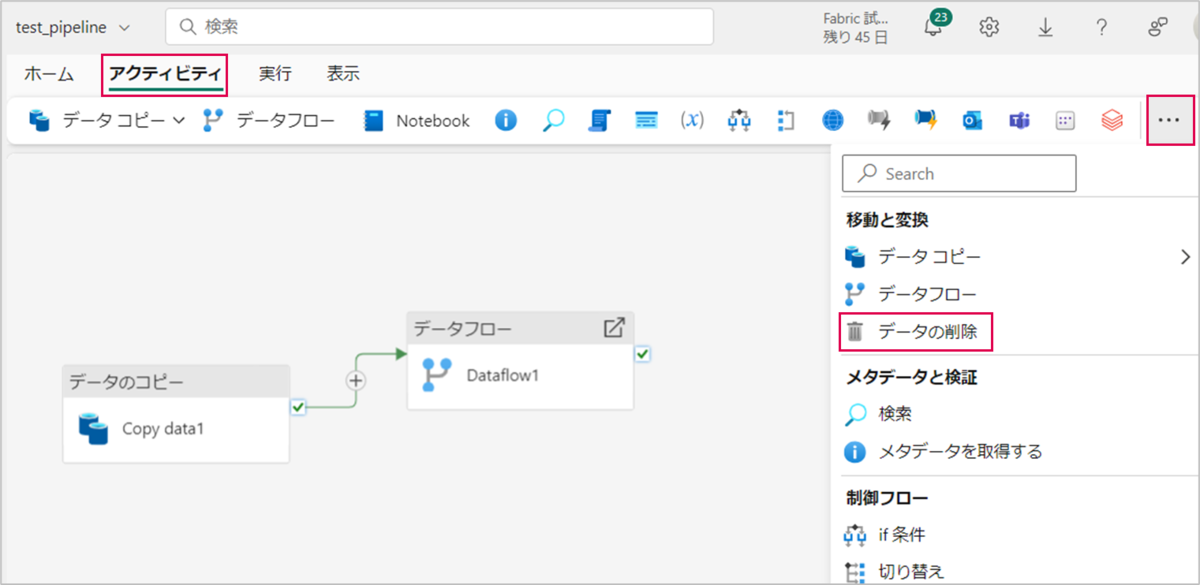

「アクティビティ」>「・・・」>「データの削除」の順に押下します。

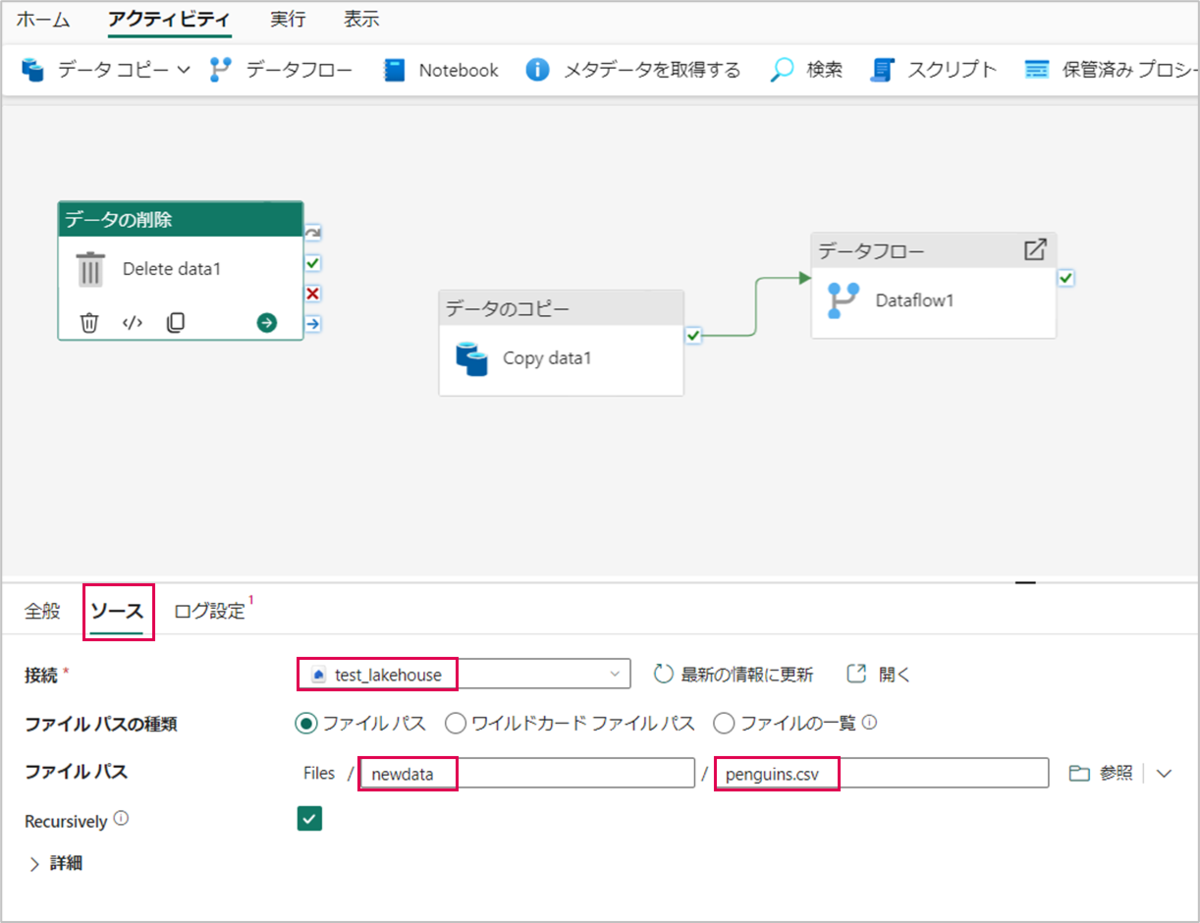

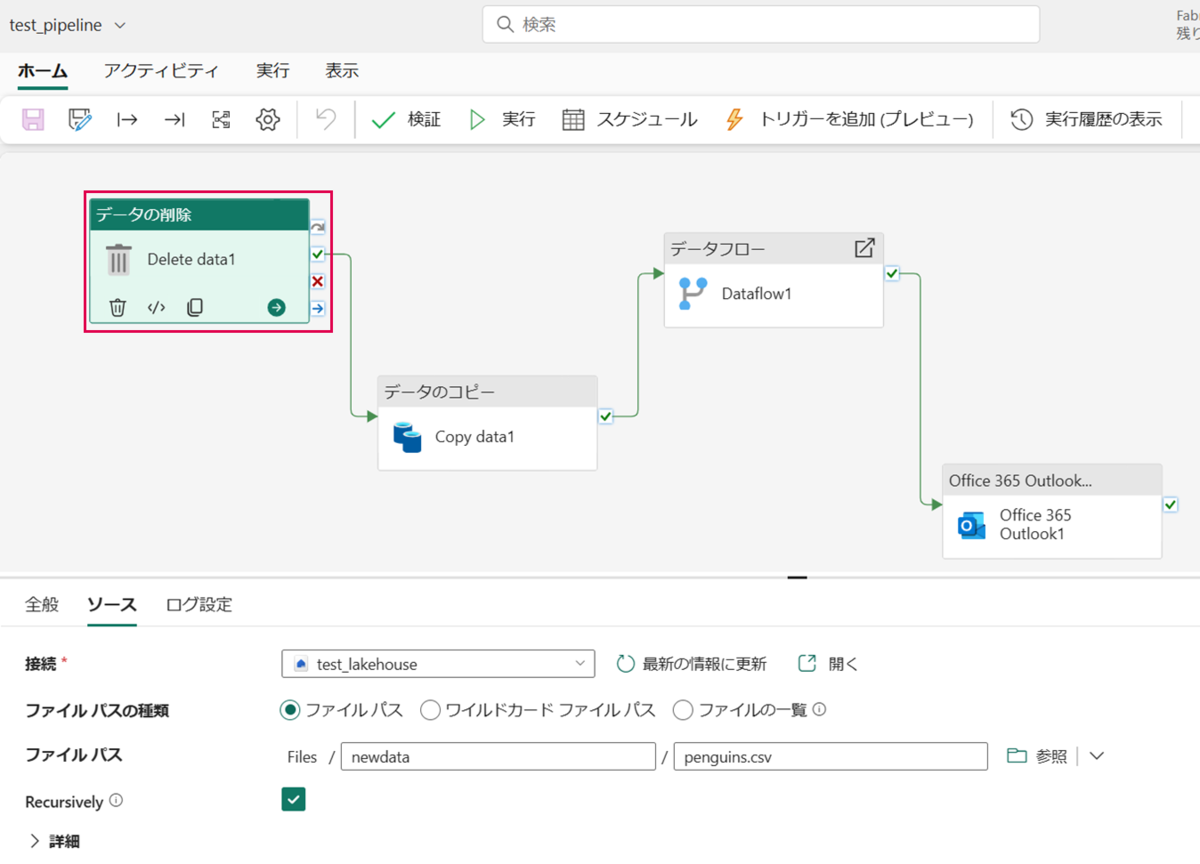

「データの削除」アクティビティの「ソース」タブを開き、下図のように設定します。

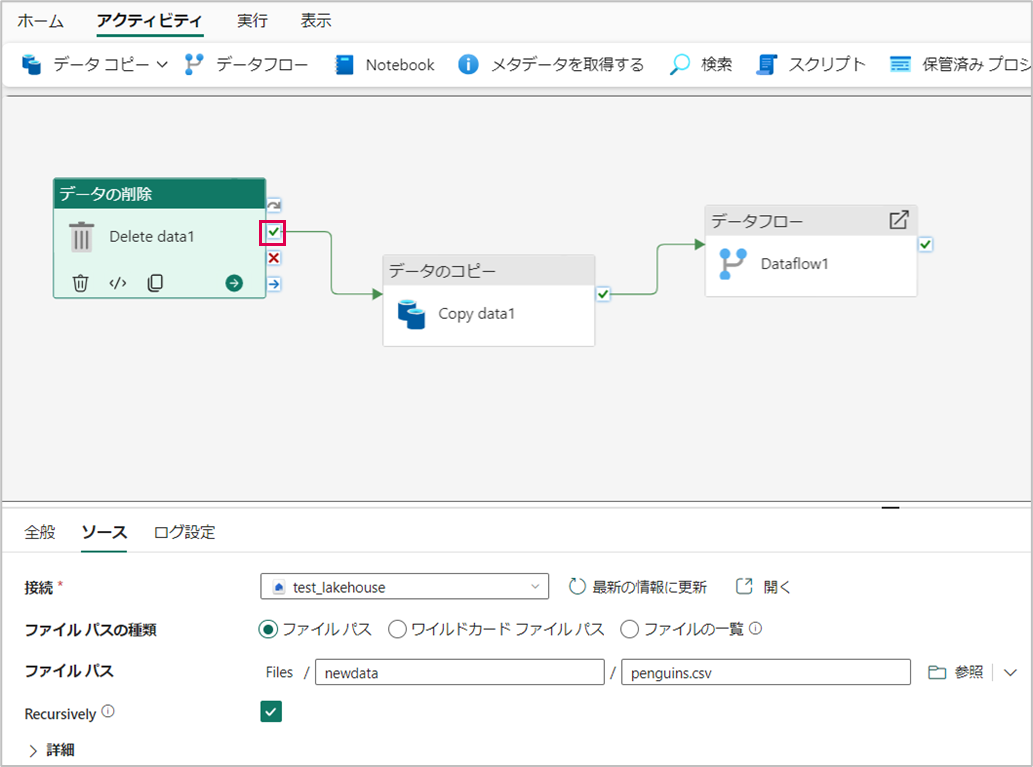

データの削除アクティビティにカーソルを合わせて、「緑色チェックマーク(成功時)」から矢印を伸ばし、データのコピークティビティに接続します。

これで、パイプライン実行時に、古いデータを削除してからデータを取得することができるようになりました。

パイプラインの通知設定

パイプライン実行成功時にOutlookへ通知する設定を行います。

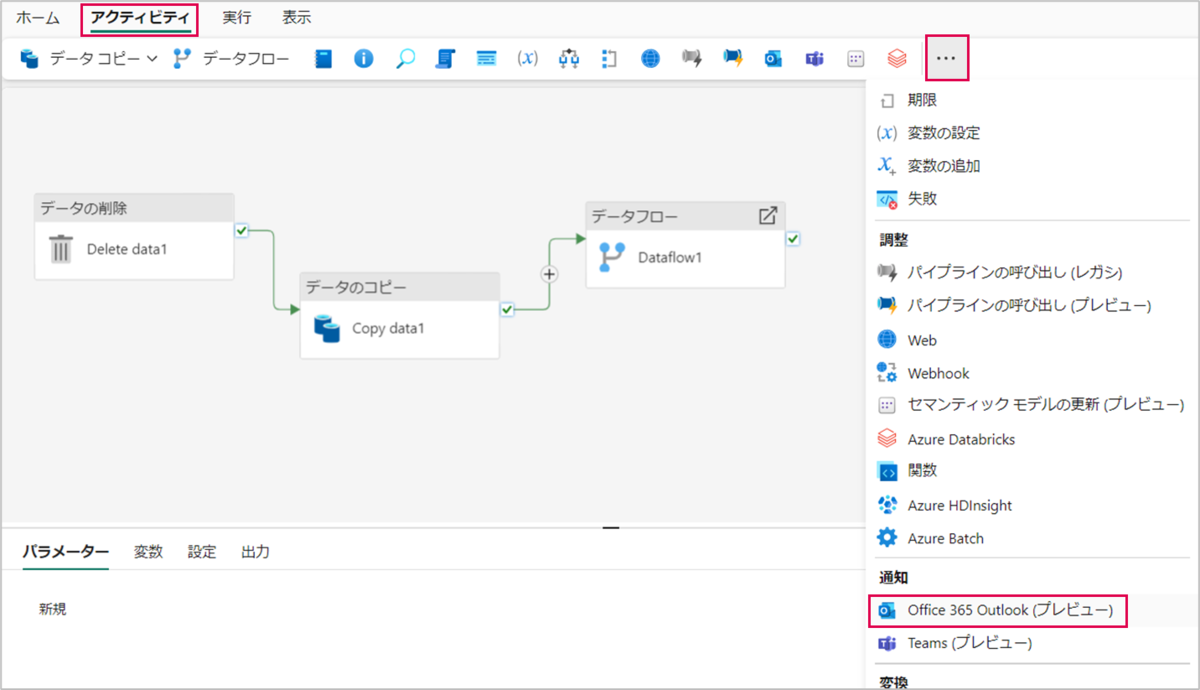

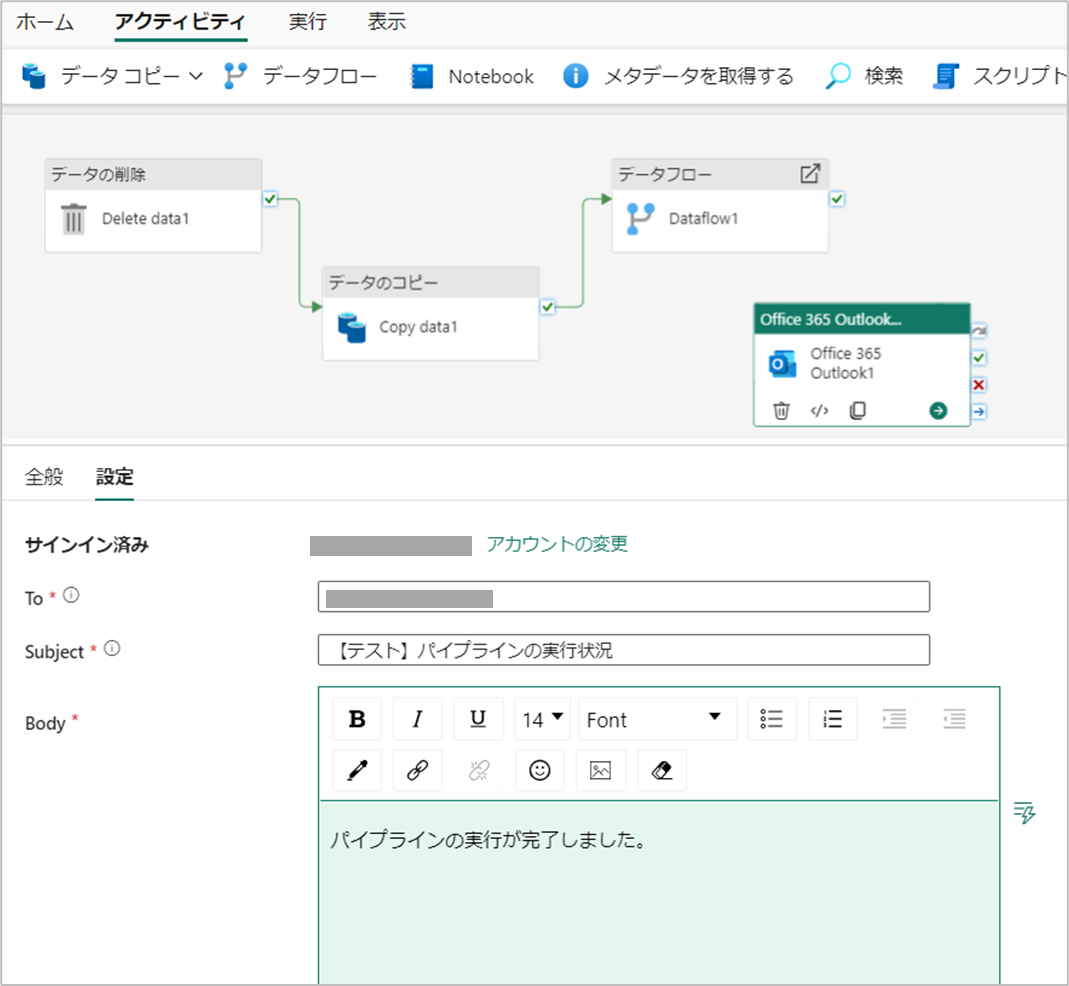

「アクティビティ」>「・・・」>「Office 365(プレビュー)」の順に押下します。

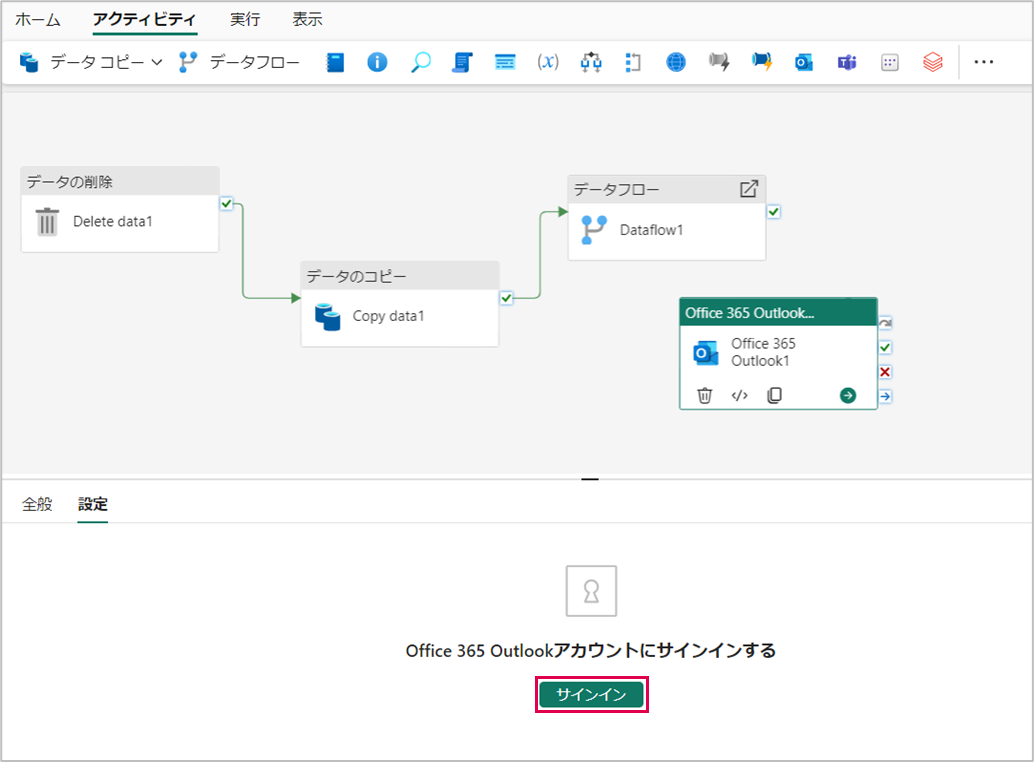

Office 365 Outlookアクティビティの「設定」タブを開き、Office 365 Outlookアカウントにサインインします。

サインインしたら、下図のように設定します。

- To:通知の宛先を入力します。今回は自分のメールアドレスを設定しています。

- Subject:メールの件名を記載します。

- Body:メールの本文を記載します。

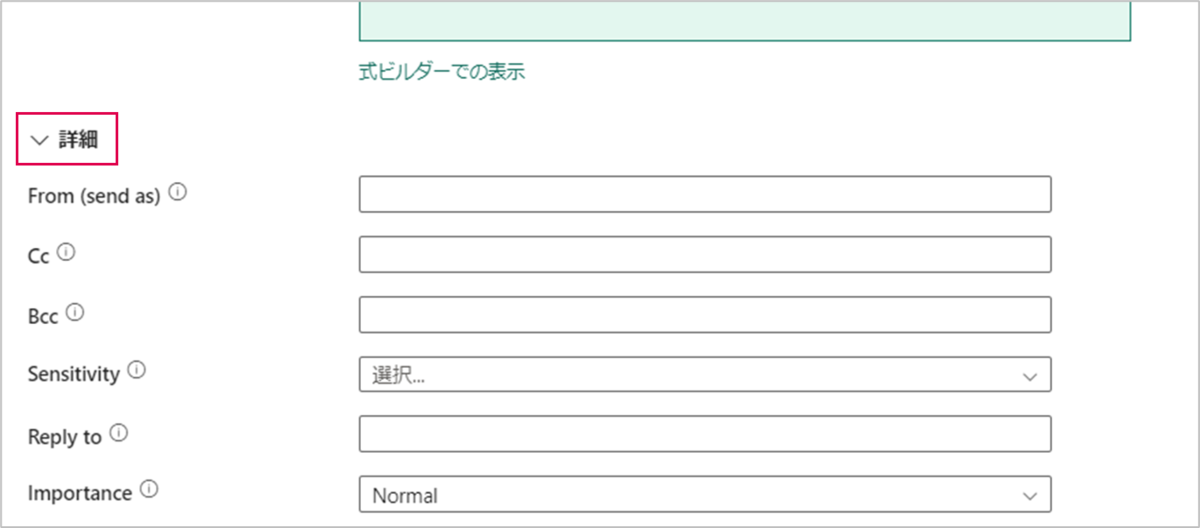

また、画面下部の「詳細」を押下すると「Cc」や「Bcc」等の設定を行うことができます。

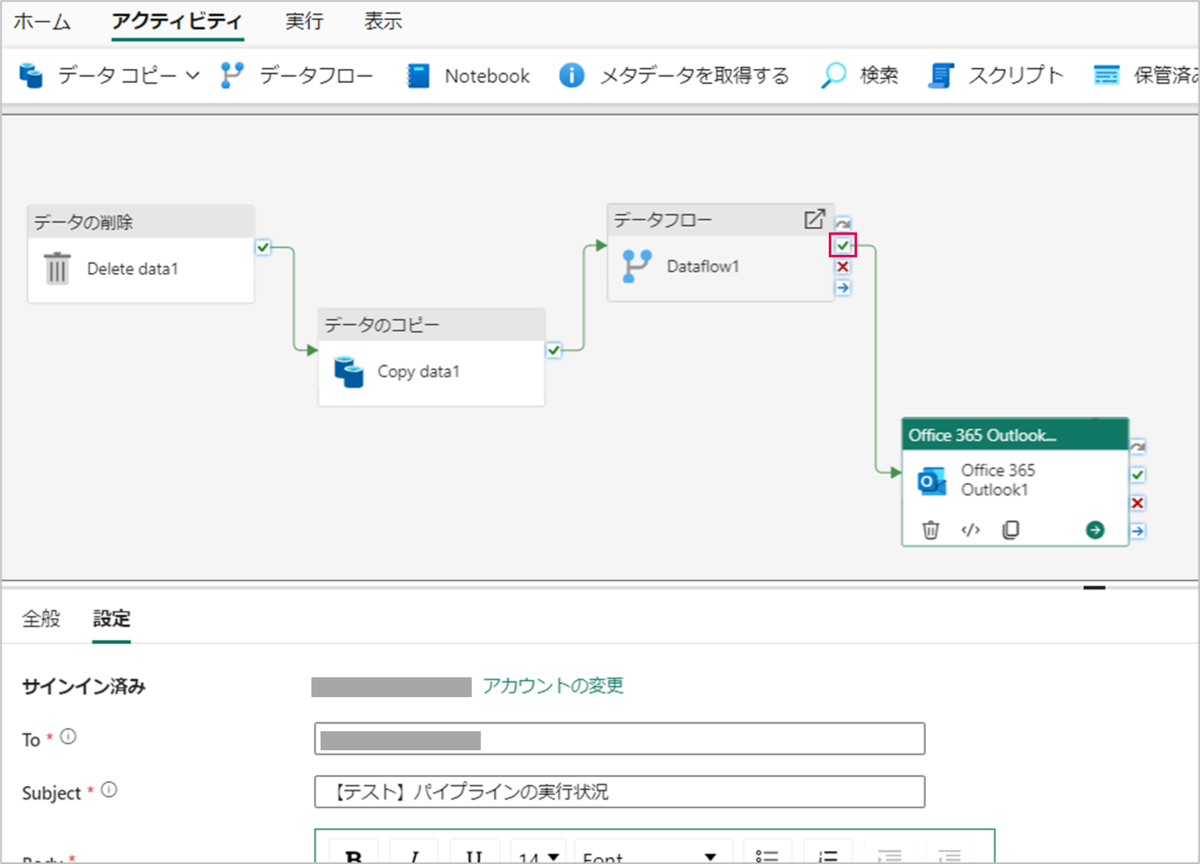

データフローアクティビティにカーソルを合わせて、「緑色チェックマーク(成功時)」から矢印を伸ばし、Office 365 Outlookアクティビティに接続します。

データフローアクティビティにカーソルを合わせて、「緑色チェックマーク(成功時)」から矢印を伸ばし、Office 365 Outlookアクティビティに接続します。

これで通知設定が完了しました。パイプラインの実行が成功すればメールで通知されます。(今回は自分宛にメールが届きます)

パイプラインの定期実行

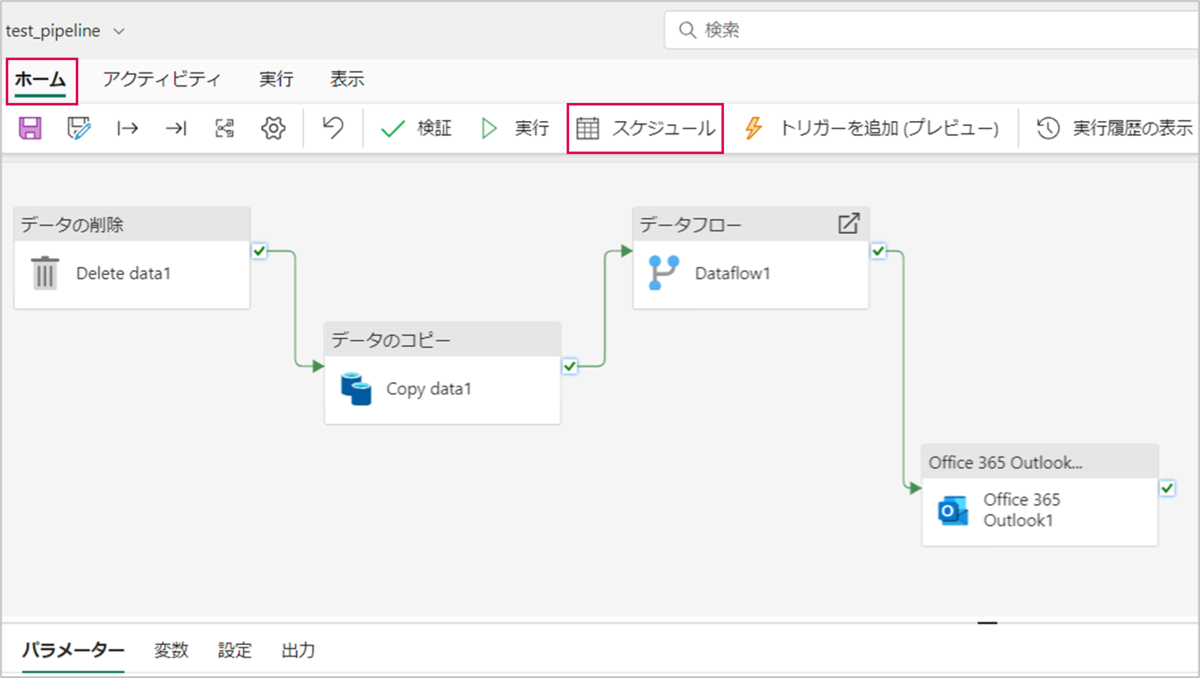

パイプラインのスケジュール機能を使用して定期実行の設定を行います。今回は、毎日18時00分(業務終了後)にパイプラインが実行(データ更新)されるように設定していきます。

「ホーム」>「スケジュール」の順に押下します。

「スケジュールされた実行」を「オン」にチェックを入れると、詳細を編集できるようになります。今回はスケジュールを以下のように設定します。

| 繰り返し設定 | 毎日 |

| 時刻 | 18:00 |

| 開始日時 | 2024/12/10 |

| 終了日時 | 2024/12/13 |

| タイムゾーン | (UTC+09:00)大阪、札幌、東京 |

最後に「適用」を押下します。

最後にパイプライン(test_pipeline)を保存します。

これでパイプラインの構築が完了しました。

データのクリーンアップについて

今回は、パイプラインが実行されるタイミングで、レイクハウスとウェアハウスそれぞれに格納されているデータがクリーンアップされます。

レイクハウスのCSVファイルは、パイプラインの「削除アクティビティ」により毎回削除されます。

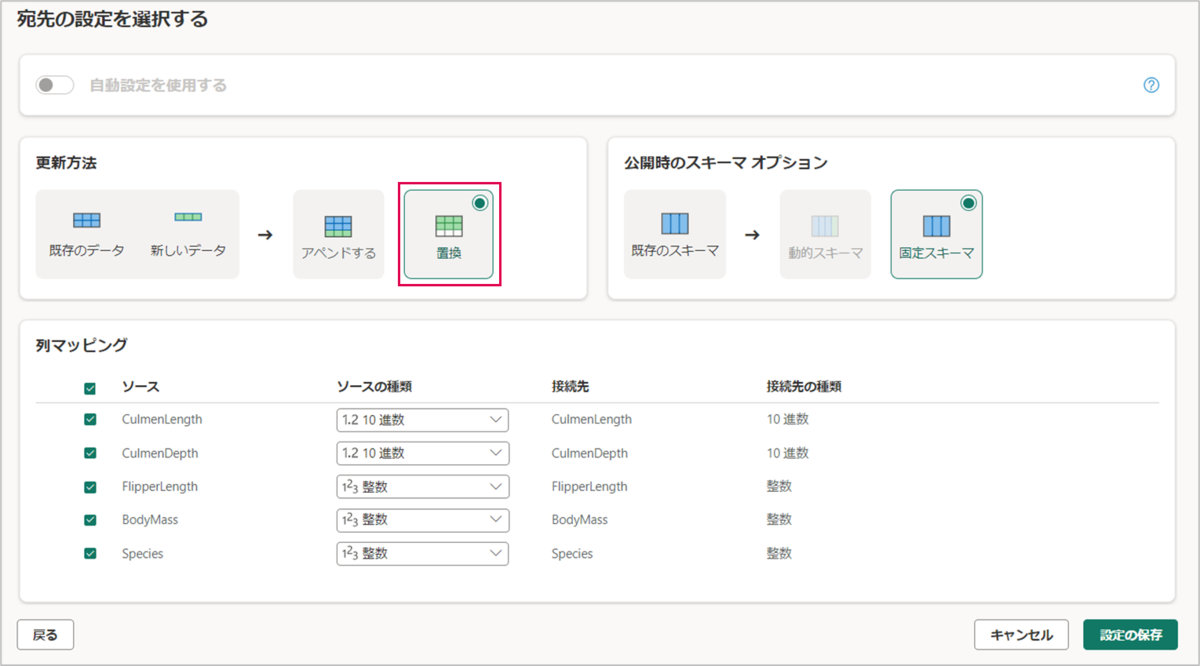

ウェアハウスのテーブルは、データフローにおける宛先設定の更新方法を「置換」にしていることで毎回上書きされます。

上記の設定により、常に最新のデータで更新されるようになります。

パイプラインの動作確認

今回は、12/10~12/13の18:00にパイプラインが実行されるスケジュールを設定しています。

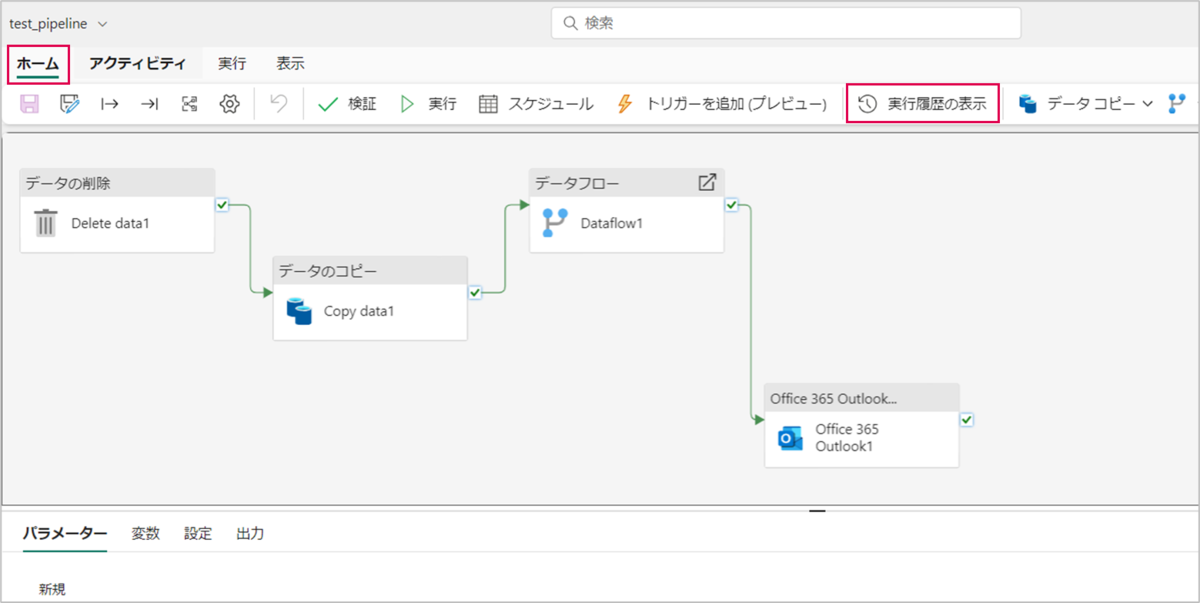

実際に、パイプライン(test_pipeline)の実行履歴を見てみます。パイプライン(test_pipeline)を開き「ホーム」>「実行履歴の表示」の順に押下します。

実行履歴を見ると、12/10~12/13の18:00にパイプライン(test_pipeline)が実行されていることが分かります。

続いて、レイクハウス(test_lakehouse)とウェアハウス(test_warehouse)の中身を確認します。

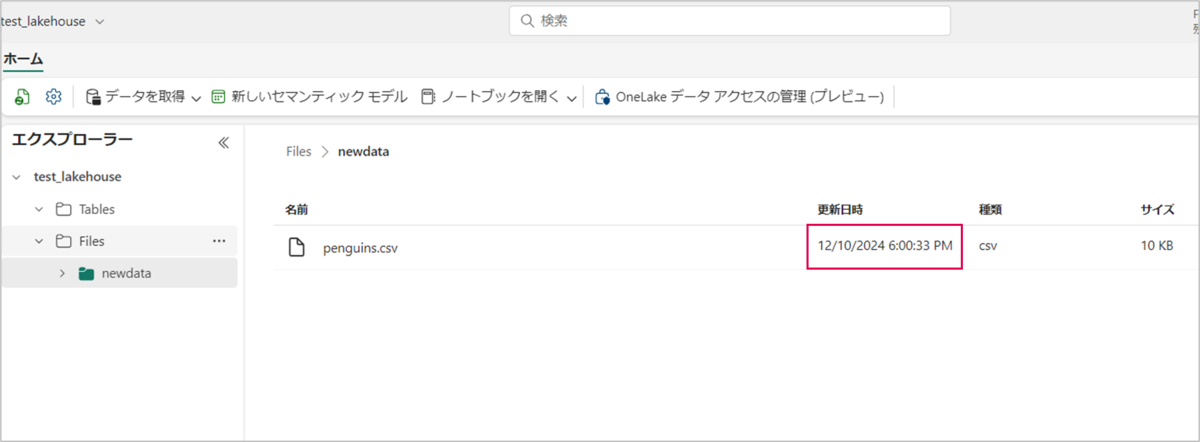

レイクハウス(test_lakehouse)を見てみると「newdata/penguins.csv」が格納されており、更新日時を見ると12/10の18:00に更新されていることが分かります。

※下記画像は12/10、18:00過ぎに確認したものになります。

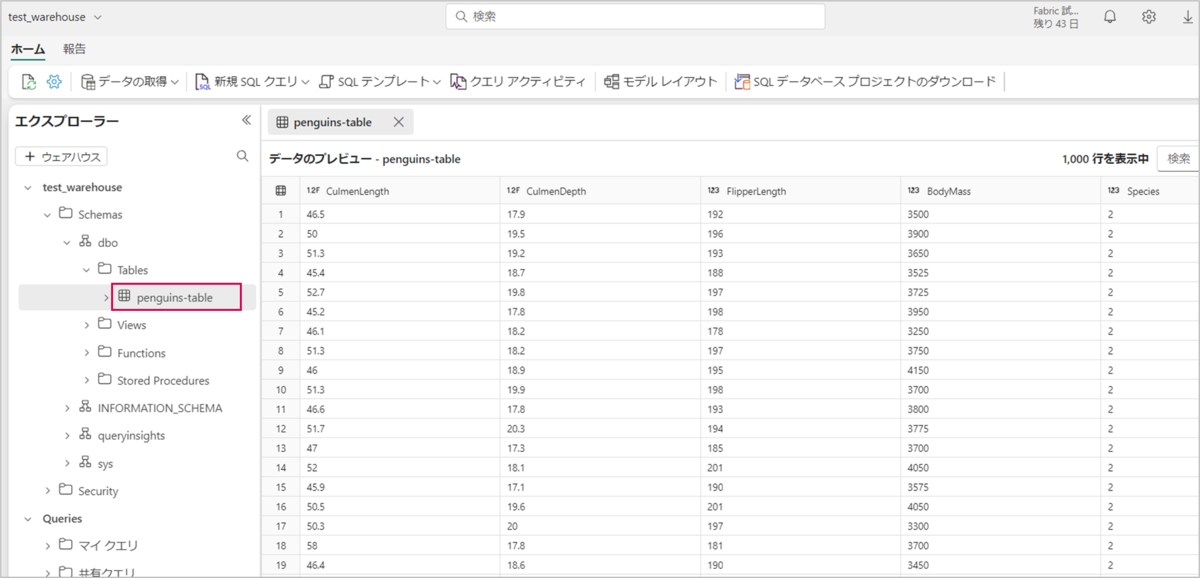

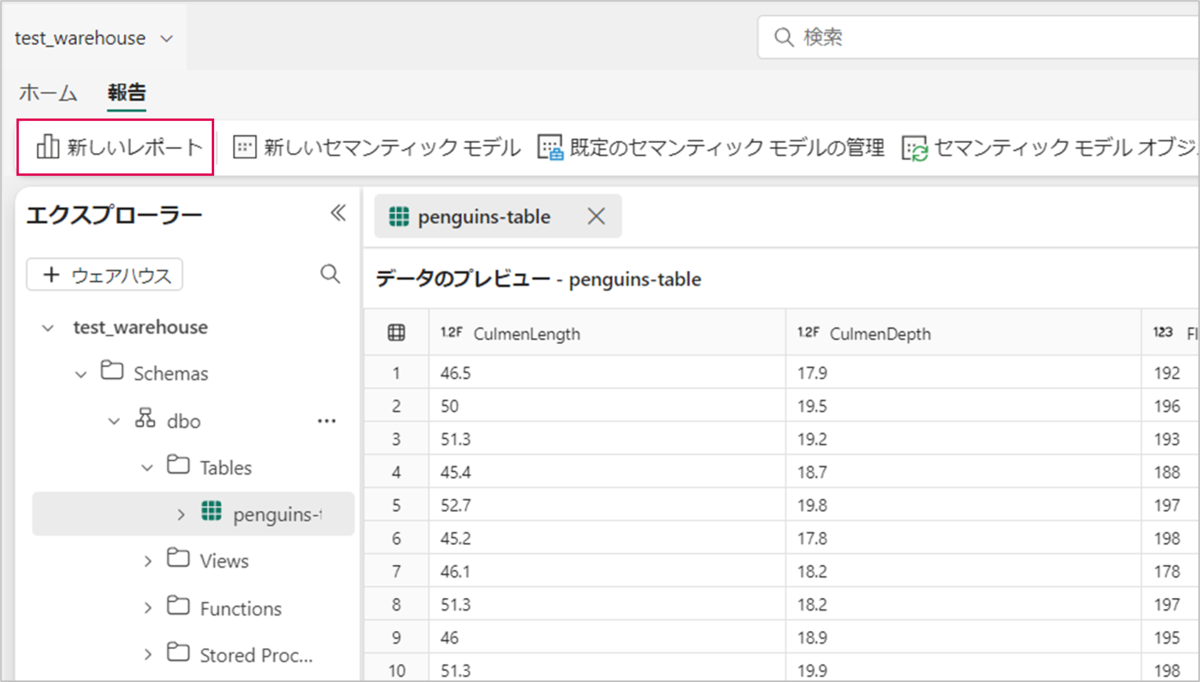

ウェアハウス(test_warehouse)を見てみると、データ加工された「penguins-table」が格納されていることが確認できます。

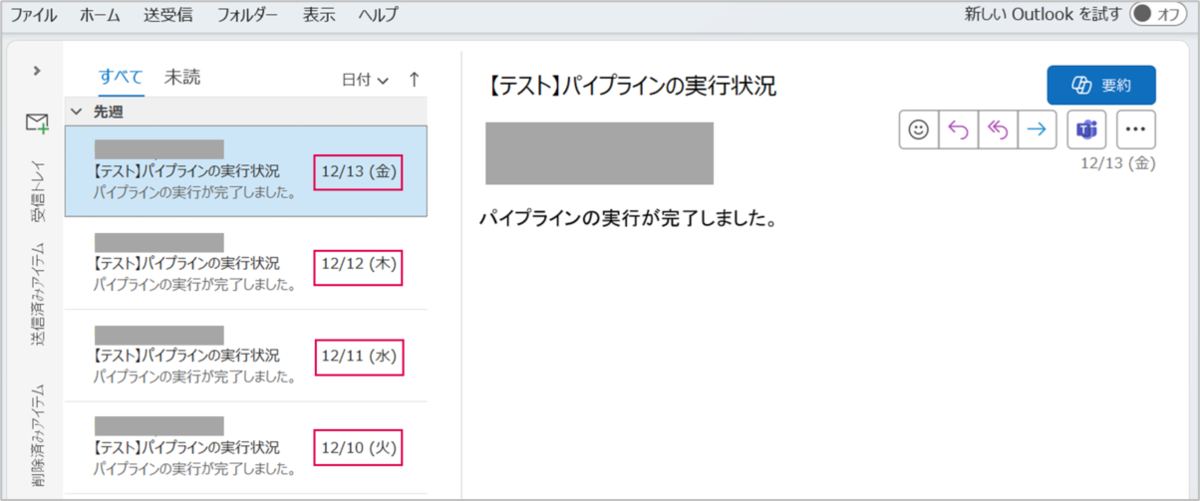

パイプライン実行成功時のメール通知も確認できました。

これで、データ処理の自動化と成功時に通知されるパイプラインを構築することができました。

データの可視化

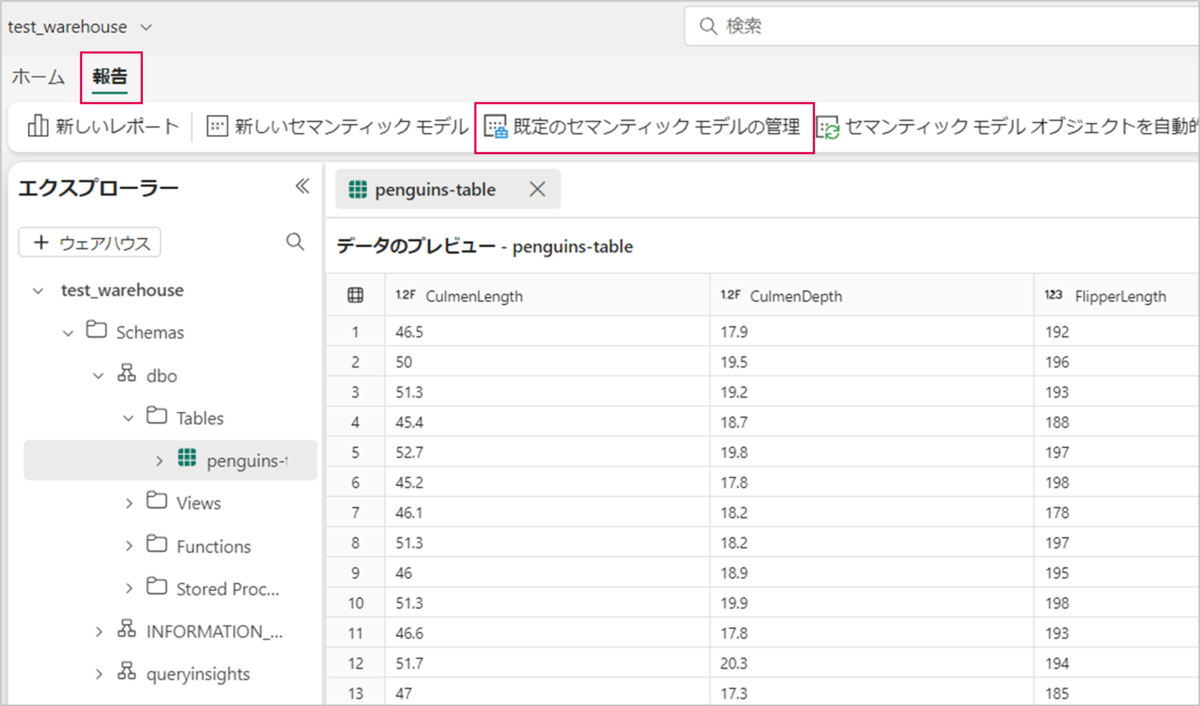

パイプライン(test_pipeline)によってウェアハウス(test_warehouse)に格納されたデータの可視化を行います。

ウェアハウス(test_warehouse)の「報告」>「既定のセマンティックモデルの管理」の順に押下します。

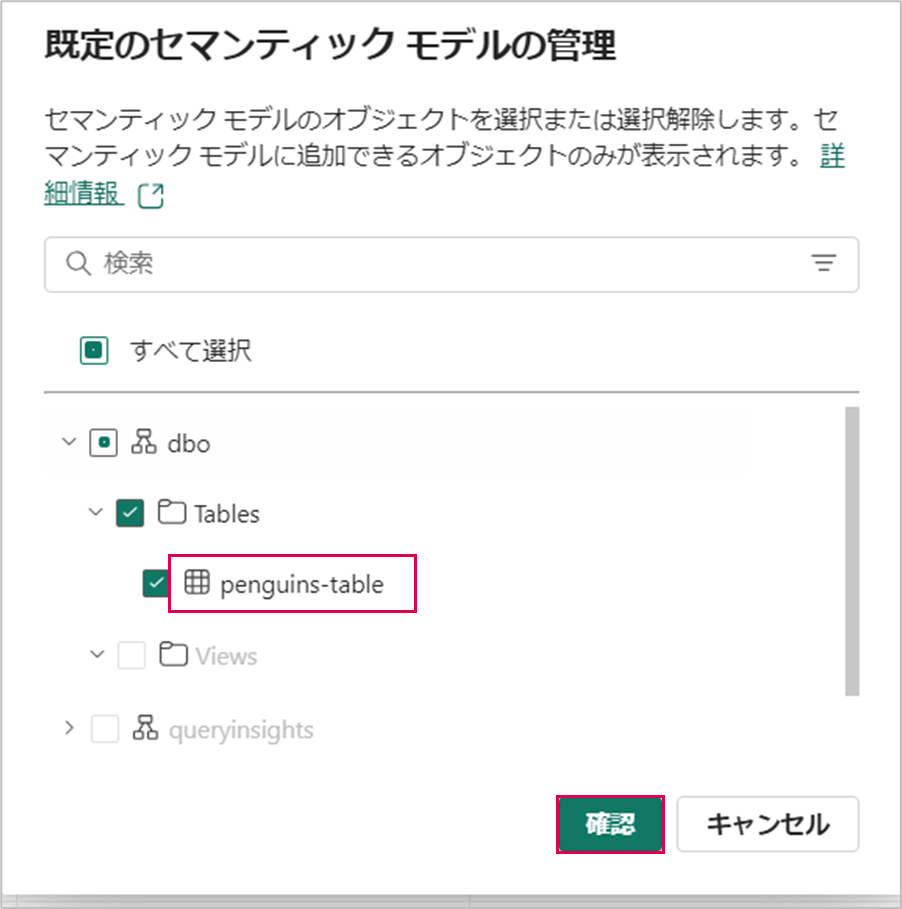

「dbo/Tables/penguins-table」を選択し、「確認」を押下します。

「新しいレポート」を押下します。

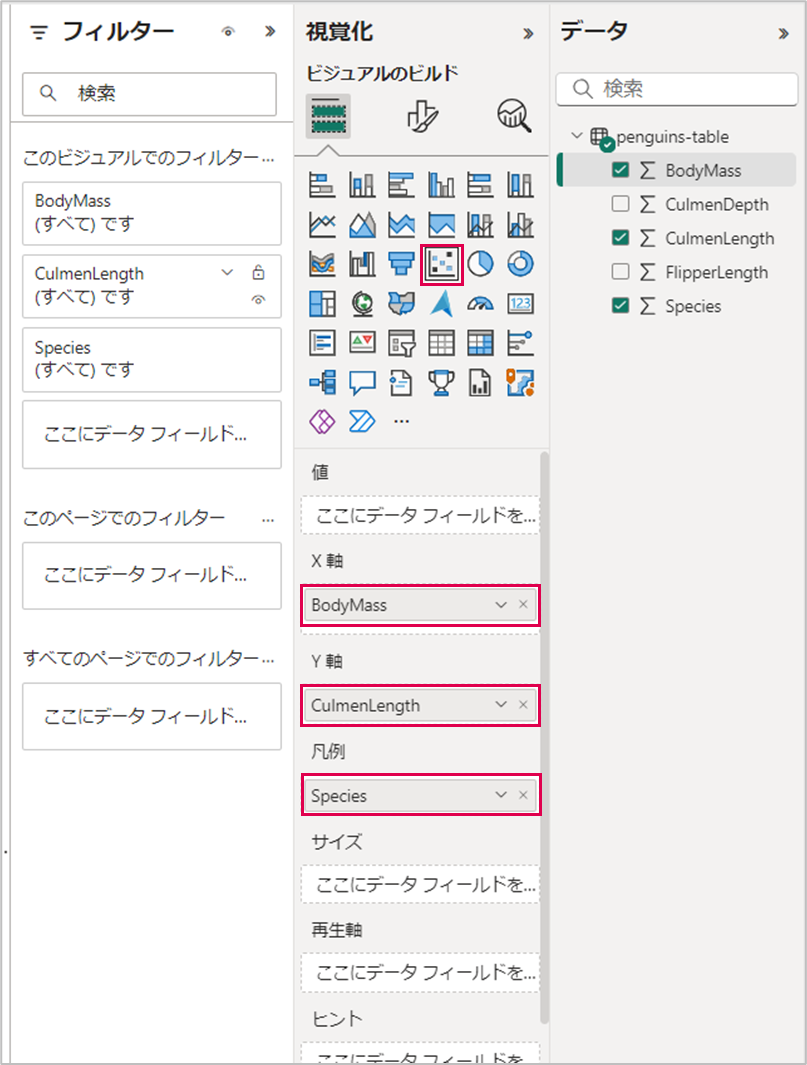

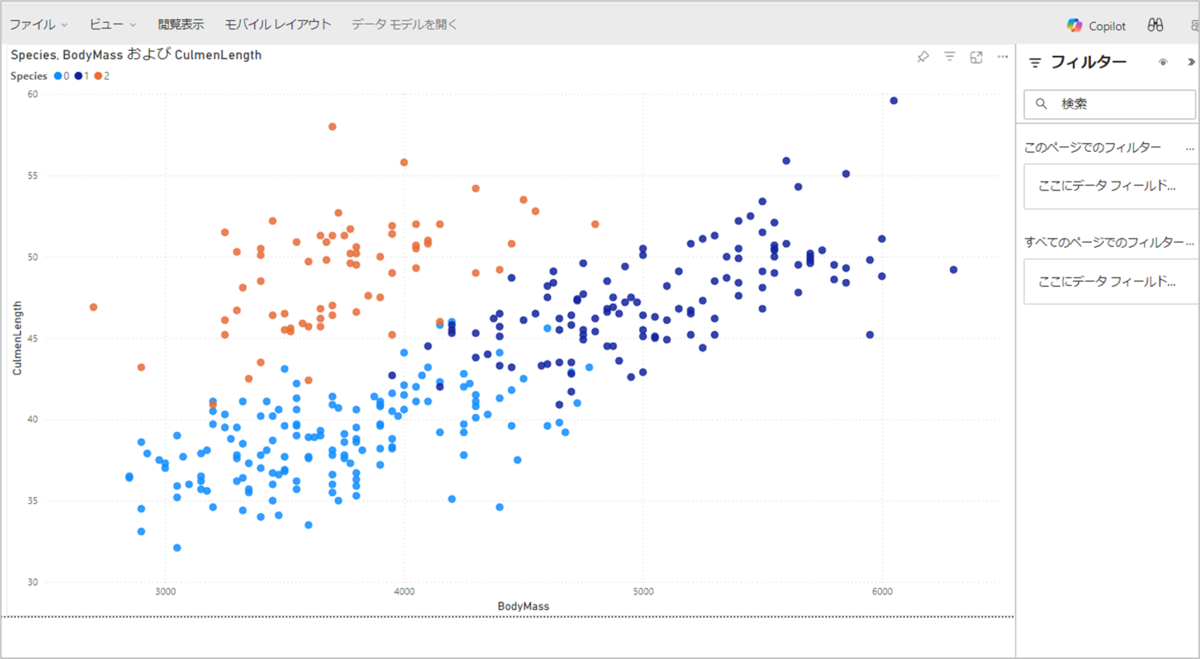

ビジュアルには「散布図」を使用し、ペンギン各種の体重とクチバシの長さの傾向を可視化していきます。

X軸に「BodyMass(ペンギンの体重)」、Y軸に「CulmenLength(クチバシの長さ)」、凡例に「Species(ペンギンの種)」とします。

これでデータの可視化が完了しました。

まとめ

Microsoft Fabricを使用してデータ処理を自動化するパイプラインの構築とパイプライン実行成功時の通知設定の手順を前編・後編に分けて紹介しました。

本記事では、パイプライン実行成功時の通知を設定しましたが、実行失敗時に通知を設定することも可能です。

また、パイプラインは「Notebook」や「ストアドプロシージャ」、「パイプラインの呼び出し」など様々なアクティビティを組み込むことができます。これにより、目的や用途に応じて柔軟にパイプラインを設計することが可能です。